Les données personnelles solubles dans le livre numérique

Les données personnelles solubles dans le livre numérique |

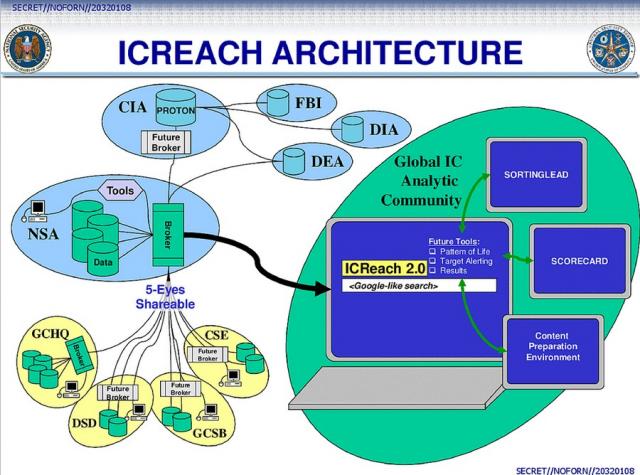

| La sécurité des utilisateurs, autant que la confidentialité de leurs données personnelles, a été mise à mal dernièrement. Découvrir que la société Adobe, comme d’autres, collecte des renseignements sur les lecteurs et leurs ouvrages est choquant. Surtout que cet espionnage, et la violation de droits constitutionnels font écho à d’autres révélations de plus vaste ampleur.

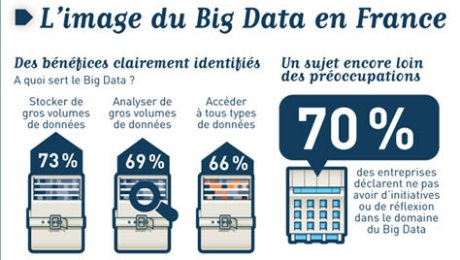

Andrew Roskill, CEO du service BiblioLabs, qui fournit les bibiothèques de prêt en contenus numériques, pose le problème de manière simple. Si l’actualité nous a appris à devenir méfiants, face aux surveillances multiples des réseaux, le contrôle de nos lectures est loin d’être supportable. Et plus encore, le livre numérique emprunté dans un établissement n’a pas vocation à devenir un ensemble de Big Data, que les sociétés pourront stocker et commercialiser.

Bien entendu, note-t-il, le modèle économique d’Amazon repose sur ce traitement des données personnelles. Le moteur de recommandation s’inspire sur les visites faites sur le site de vente, ainsi que les achats, le tout recoupé avec les données des autres clients. « Mais il y a une différence entre le comportement d’achat et celui de lecture, et nous aimons à penser que nos lectures restent confidentielles », poursuit-il.

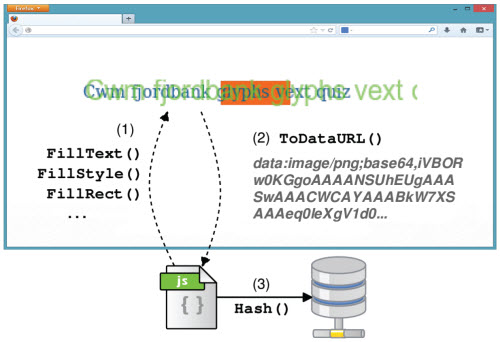

Le sentiment de sécurité offert par le prêt de livres papier, et qui est garanti dans la législation américaine, devrait être reproduit dans l’univers dématérialisé. Ainsi, les révélations portant sur le comportement du logiciel d’Adobe, Digital Edition ont causé du tort au service de prêt numérique. Non seulement ADE surveillait les lectures, mais, surtout, les diffusait à ses serveurs sans aucun cryptage. Ce dernier point a été reconnu, et corrigé, mais le premier reste d’actualité.

« Certains fournisseurs ont tenté de faire valoir que la collecte de données personnelles est nécessaire pour améliorer l’expérience de l’utilisateur, que les serveurs ont besoin de données spécifiques à l’utilisateur pour synchroniser les ebooks à travers les dispositifs, permettant aux lecteurs de passer d’un lecteur à un autre, sans perdre le fil du récit », rappelle Roskill.

Sauf que pour assurer un suivi des lectures, d’un appareil à l’autre, il n’est pas du tout obligatoire de collecter les données personnelles des utilisateurs, affirme-t-il. Et il n’est pas vrai non plus que les éditeurs ou les libraires ont besoin de données individuelles pour suivre les comportements d’achats – et, éventuellement, orienter leur ligne éditoriale. Une agrégation de données suffirait amplement pour avoir une vue d’ensemble satisfaisante.

Bien entendu, les services de BiblioLabs proposent un anonymat maximal, promet-il, et garantissent une sécurisation des données transférées. « La confidentialité et la sécurité sont extrêmement importantes pour les bibliothèques et leurs usagers. » Parce que, ce qui prime, c’est la confiance que ces derniers accordent aux établissements, pour que les bibliothèques elles-mêmes puissent avoir envie de recourir aux services les plus respectueux. (via BookBusiness Mag)

Après cette lecture, quel est votre avis ?

Source : https://www.actualitte.com/usages/les-donnees-personnelles-solubles-dans-le-livre-numerique-54229.htm

|