| Alors que le gouvernement propose une application pour les alertes aux attentats, Gaël Musquet, hacker et militant du logiciel libre, presse l’Etat d’adopter la diffusion cellulaire, plus efficace et respectueuse de la vie privée.

Alors que le gouvernement propose une appli pour les alertes aux attentats, Gaël Musquet, hacker et militant du logiciel libre, presse l’Etat d’adopter la diffusion cellulaire, plus efficace et respectueuse de la vie privée.

Le gouvernement a dévoilé mercredi une application, «SAIP» (pour «Système d’alerte et d’information des populations»), permettant d’alerter en direct ses utilisateurs en cas d’attentat à proximité. Une bonne initiative, mais une réponse technologique inappropriée, estime Gaël Musquet, hacker en résidence à la Fonderie, l’Agence numérique publique d’Ile-de-France. Car des normes internationales existent déjà pour transmettre une alerte sur tous les téléphones des populations menacées par un risque, sans qu’elles aient besoin d’installer une application, et en respectant leur vie privée.

Que penser de cette application d’alerte gouvernementale ?

Prévoir un protocole d’alerte aux populations est une bonne initiative, on va dans le bon sens. Nous n’avons pas une grande culture du risque en France, donc toutes les occasions d’en parler sont bonnes à prendre ! Cela permet de faire de la pédagogie, d’informer et de former les populations. Car c’est le manque de préparation qui crée de la panique, et malheureusement, parfois des morts. Et puis franchement, les sirènes d’alerte ne sont comprises par personne, donc il est temps de rafraîchir le système avec un peu de technologie.

Le taux d’équipement en smartphones permet aujourd’hui de toucher un maximum de personnes quand on développe une application sur les deux principales plateformes, iOS et Android. Le gouvernement a eu une démarche d’ouverture, en consultant par exemple Visov, une association de volontaires spécialistes de la gestion d’urgence – ils font de la pédagogie auprès des pompiers, des gendarmes ou de l’Etat, entre autres, sur l’utilisation du Web et des réseaux sociaux en cas de crise. Le développement de SAIP est encore en cours, et il appartient au Service d’information du gouvernement [SIG] de recueillir les premiers retours pour améliorer le service. Il a fait cette application de la manière la plus agile possible, on ne peut pas lui faire de reproche là-dessus.

Mais… ?

Il y a plusieurs problèmes avec cette démarche. D’abord, l’application SAIP s’appuie sur les données internet des smartphones, donc sur les réseaux 3G, 4G et wifi qui sont potentiellement vulnérables. Quand il y a trop de téléphones dans une certaine zone et pas assez de canaux disponibles pour pouvoir router tous les appels, les antennes-relais sont saturées et elles ne peuvent plus répondre. Ça se passe régulièrement dans les événements où il y a foule : pendant les attentats de Boston, au discours d’investiture d’Obama mais aussi le 13 Novembre, il y a eu ce qu’on appelle un Mass Call Event (MCE). C’est aussi le cas localement dans des quartiers à cause de concerts, festivals… Quand on sait à l’avance qu’il y aura trop d’appels durant un événement, on installe des antennes-relais supplémentaires pour couvrir le risque de saturation. C’est ce qui va se passer pour l’Euro de foot. Mais en cas de crise imprévue, les infrastructures ne résisteront pas, ni pour les appels, ni pour les SMS, ni pour les données internet. Ce sont des lois physiques, on ne peut rien y faire. Dans ce genre de situation, SAIP sera dans les choux.

Ensuite, il faut faire attention à ne pas morceler le système d’alerte avec de multiples applications de gestion de crise. Il existe une appli pour le risque d’attentats en France, une pour les séismes du Centre sismologique euroméditerranéen, une autre pour mes vacances en Russie et une pour les alertes de l’Indre-et-Loire… Il y a aussi des entreprises privées qui développent leurs propres applications d’alerte, et des fois, comme pour les risques d’avalanches, elles sont meilleures que celles de l’Etat. La concurrence entre les acteurs est contre-productive pour toucher un maximum de personnes. Il vaut mieux un système universel qui puisse aussi s’adresser, par ailleurs, aux touristes de passage en France.

Enfin, il y a la question du respect de la vie privée. Beaucoup d’internautes s’inquiètent déjà, sur Twitter, que l’Etat puisse savoir en permanence où je me trouve via les données de géolocalisation récoltées par cette application. Et il existe effectivement un risque que ces données soient piratées, quels que soient les efforts de sécurisation. Et puis, comme ce n’est pas un logiciel libre, on ne connaît pas son code source et la communauté des développeurs ne peut pas aider à corriger les bugs, faire des stress tests pour vérifier son fonctionnement dans des conditions d’usage intense…

Y a-t-il une meilleure solution ?

A court terme, c’est bien d’avoir une application d’alerte. Mais à long terme, on n’y coupera pas : il faut que la France respecte les standards internationaux de la diffusion cellulaire – cell broadcast en anglais. C’est une norme qui existe déjà pour la diffusion des alertes, et qui permet d’informer toutes les personnes présentes dans la zone de couverture d’une antenne-relais. On n’a pas besoin de connaître leur numéro de téléphone ni de leur faire installer une application : dans la région prédéfinie, tout le monde sans exception reçoit le SMS, y compris les touristes avec un forfait étranger ! C’est une technologie non intrusive qui respecte la vie privée des citoyens. Elle ne se limite pas aux possesseurs d’iPhone et d’Android, même pas besoin d’avoir un smartphone : l’alerte arrive même sur les petits téléphones. Ça tombe bien : en France, 92 % des personnes de plus de 12 ans ont un téléphone, mais 58 % seulement ont un smartphone. Et puis la norme cell broadcast prévoit que les messages d’alerte passent au-dessus de la mêlée dans le trafic téléphonique.

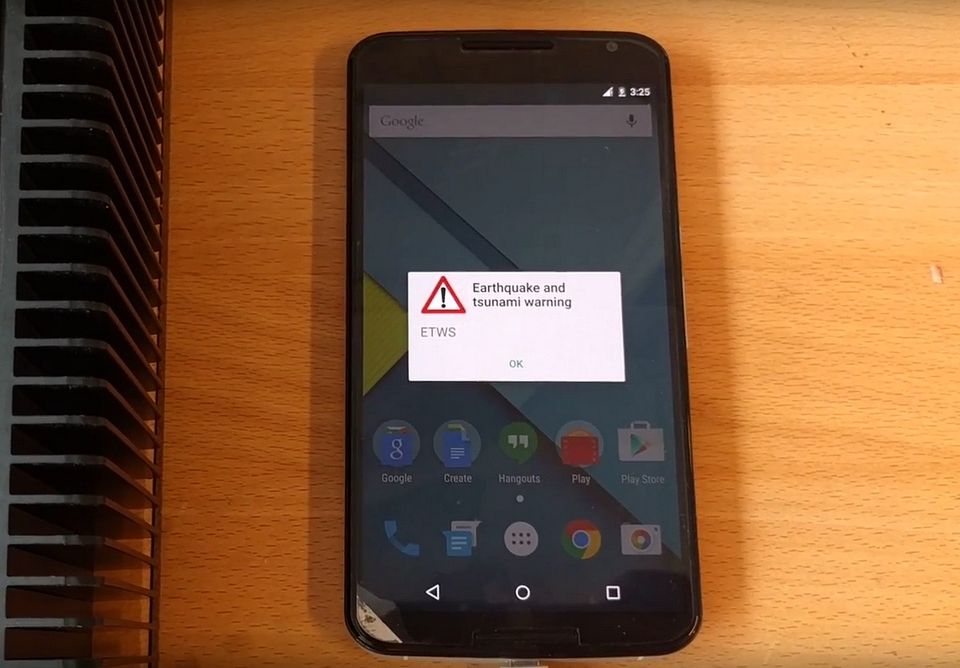

[youtube https://www.youtube.com/watch?v=2jbh9Twro3o?feature=oembed&w=610&h=343]

Simulation d’une alerte en diffusion cellulaire sur Android.

La norme du cell broadcast est définie depuis 1995 (pdf et pdf). Elle a même été testée à Paris en 1997 : tout est déjà là ! Depuis, elle a évolué pour supporter les alertes enlèvement (Amber), les séismes et les tsunamis (système ETWS). Avec l’arrivée de la 4G, le protocole a encore été étendu et on peut même l’utiliser pour diffuser des vidéos, aujourd’hui. Vingt ans plus tard, la diffusion cellulaire a été déployée par nos voisins – Espagne, Portugal, Italie, Finlande, Pays-Bas, Chine, Etats-Unis, Israël… Et la France brille par son absence.

Nous devons, nous aussi, la mettre en place dans le cadre d’une véritable politique numérique de l’alerte. Il y a là un enjeu de sécurité publique. Cette norme doit être imposée à nos opérateurs téléphoniques, comme un service public de l’alerte, comme on a imposé la mise en place du 112. C’est une question d’intérêt général. Pourquoi ne respectons-nous pas les normes et standards internationaux en matière d’alerte, documentés, ouverts et qui ont fait leurs preuves ?

Pourquoi n’a-t-on pas encore déployé la diffusion cellulaire en France ?

C’est fragile et ça coûte cher, nous dit-on. Oui, ça coûte cher, mais pas plus que la Hadopi ! On a su débloquer des budgets pour les lobbys de l’industrie culturelle et créer, entretenir, maintenir l’Hadopi à grands frais en contraignant les opérateurs à suivre. Idem pour l’espionnage de masse avec les lois sur la surveillance. Si tu es capable de m’espionner, alors tu es capable de m’informer en cas de crise. Est-ce que notre sécurité vaut moins que les doléances d’autres lobbys ? Nos vies sont-elles moins chères que la Hadopi ?

La mise en place du cell broadcast demande effectivement, quoique pas obligatoirement, de légiférer. Ça demande ensuite que les systèmes d’information des préfectures soient reliés aux systèmes d’information des opérateurs téléphoniques : il faut des passerelles pour que l’alerte passe de la préfecture à SFR, Bouygues et compagnie. Ça demande de la réflexion et un chantier technique. A part ça, c’est simple : les antennes-relais respectent déjà la norme.

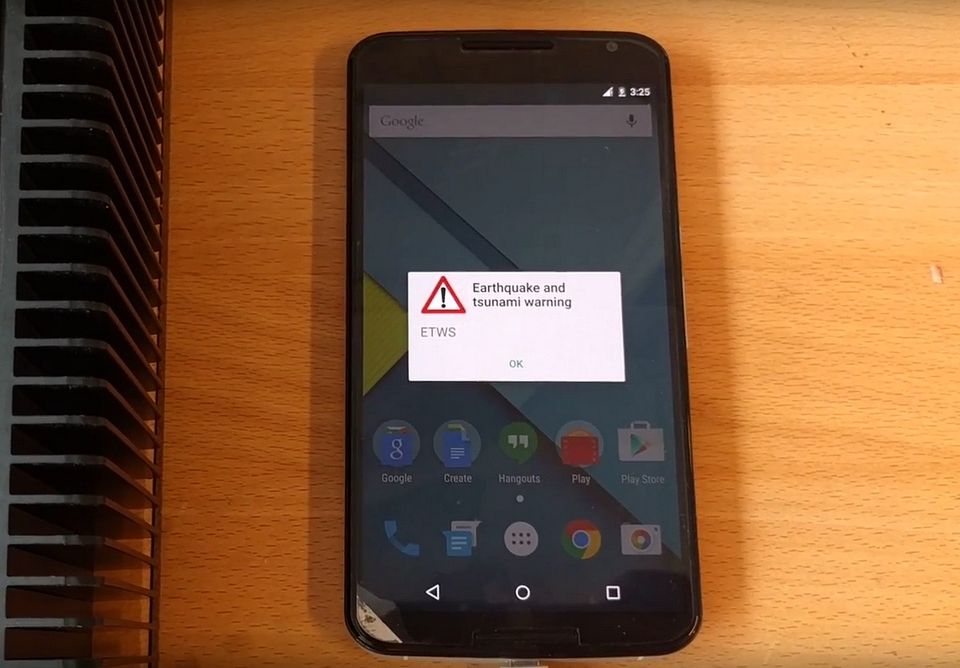

[youtube https://www.youtube.com/watch?v=q390CHXLklw?feature=oembed&w=610&h=343]

Simulation d’une alerte en diffusion cellulaire sur iPhone.

Il faut juste activer l’option. Nos voisins chiliens ont su le faire pour se protéger des tsunamis ; en septembre 2015, il leur a fallu quelques dizaines de minutes seulement pour évacuer des milliers de personnes après le séisme. Il n’y a pas de raison que la France n’y arrive pas aussi !

C’est une question plus générale de culture du risque…

L’alerte est une chose, oui, mais ce n’est pas suffisant. La France est un pays qui fait face à tous les risques possibles, mais nous n’avons pas de culture du risque. Alors que les risques, eux, sont bien là. Notre mémoire est courte mais nous avons des catastrophes naturelles bien plus meurtrières que le terrorisme : 500 morts après la rupture du barrage de Malpasset en 1959, 46 morts avec le séisme provençal de 1909, 29 000 morts pour l’éruption en 1902 de la Montagne Pelée, 70 000 morts dans le tsunami de 1908 à Messine, et même 29 morts récemment à La Faute-sur-Mer et 17 morts dans les inondations de la Côte d’Azur en octobre 2015.

Il faut faire des exercices : un barrage a lâché, que fait-on ensuite ? Les gens paniquent quand ils ne savent pas quoi faire, on l’a encore vu la semaine dernière avec les crues. Il faut des exercices communaux pour expliquer les procédures aux habitants des villes, former des gens à l’utilisation des réseaux sociaux en cas d’urgence pour contrer les rumeurs et diffuser les informations, former des pilotes de drones et des radioamateurs : le jour où il y a un vrai black-out de téléphonie, qui saura faire la transmission des informations ? Au-delà d’événements très médiatiques comme les hackathons ou les simulations entre experts, nous devons impliquer la société civile dans des exercices réguliers.

Commençons à expérimenter sur des territoires français de petite taille, en proie à des crises cycliques – Guadeloupe, Martinique, Réunion, Polynésie… Des formats d’événements existent déjà. CaribeWave, IndianWave et PacificWave sont par exemple des exercices annuels d’alerte au tsunami, auxquels je participe. Les Etats-Unis organisent un «préparathon» contre les catastrophes naturelles.

2016 est l’année de la présidence française de l’Open Governement Partnership. Pour un gouvernement ouvert, à nous, société civile, de nous prendre en charge, nous investir dans les exercices et les réflexions pour une meilleure information et une meilleure préparation aux crises.

Vendredi après-midi, tout le matériel technologique ayant servi à CaribeWaveFWI, la dernière simulation d’alerte au tsunami, sera exposé à la Gaîté Lyrique à Paris, dans le cadre du festival Futurs en Seine.

Article original de Camille Gévaudan

Réagissez à cet article

|