La France aurait-elle peur de Intelligence artificielle ?

|

La France aurait-elle peur de Intelligence artificielle ? |

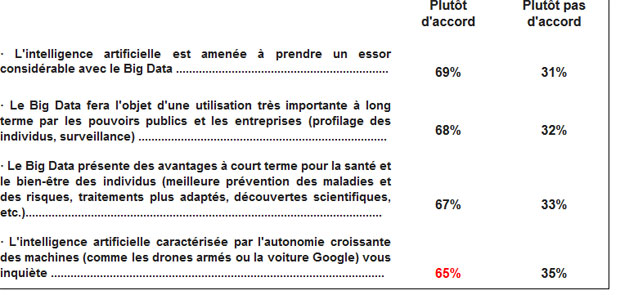

| L’intelligence artificielle caractérisée par l’autonomie croissante des machines, ça vous fait peur ? 65% d’un panel de Français répondent oui. Mais pour quelles raisons sont-ils inquiets ? Et aujourd’hui, l’IA, c’est quoi au juste ? Pas sûr qu’une majorité de Français puissent cette fois répondre.

Non, ne paniquez pas, vous n’êtes pas pris dans une boucle spatiotemporelle et de retour en février 76, avec sur l’écran, face à vous, Roger Gicquel. Relativisons dès à présent. La France n’a pas peur de l’intelligence artificielle. Mais une majorité de Français d’un panel de 10004 personnes se déclare plutôt d’accord lorsqu’on lui demande si l’intelligence artificielle « caractérisée par l’autonomie croissante des machines (comme les drones armés ou la voiture Google) » l’inquiète.

Des effets de génération dans les craintes Ainsi les 25-34 ans sont, en proportion, aussi inquiets (69%) que les 65 ans et plus (70%), bien plus en tout cas que les 18-245 ans (50%). De même, les résultats de l’étude font état de disparité géographique et en fonction du niveau de diplôme sur cette question. « Il existe donc des effets de génération dans les craintes qui ne tiennent pas simplement à la jeunesse, à l’âge et au niveau d’éducation » commente dans un communiqué Jean-Gabriel Ganascia, professeur à l’Université Pierre et Marie Curie (Paris VI). Les Français sondés sont donc en majorité inquiets, soit. Mais, et la question n’est pas pédante, combien de ces Français sont au fait des travaux autour de l’IA et de ses usages concrets ? Très certainement une très faible portion, car les notions et savoirs scientifiques associés à ce domaine de recherche s’avèrent d’une très grande complexité. « Aujourd’hui beaucoup d’entreprises, dont Facebook, partagent cette même vision, à savoir que les problèmes que nous cherchons à résoudre sont infiniment complexes. Et même si nous employons les meilleurs talents, ce n’est pas suffisant pour résoudre ces problèmes comme celui de l’apprentissage non supervisé » expliquait ainsi Florent Perronnin, directeur du laboratoire de recherche parisien de Facebook dédié à l’intelligence artificielle.

« La peur est dans la population parce qu’elle ne sait pas de quoi on parle » « La séduction [à l’égard de l’IA] est du côté de ceux qui sont dans le milieu de l’informatique robotique, et chez les fans de science-fiction. La peur est dans la population parce qu’elle ne sait pas de quoi on parle. Elle est influencée par la littérature, le cinéma, les séries, où la machine finit par tourner mal, se retourne contre l’homme et le détruit. » Cela ne signifie pas néanmoins que l’intelligence artificielle ne puisse pas être une source légitime d’inquiétude ou de questionnement, mais alors pour des risques bien différents de ceux qui pourraient être imaginés par certains, comme des machines douées de conscience se retournant contre leur créateur. « Ceux d’entre nous en première ligne dans la fourniture de code sont très excités par l’intelligence artificielle, mais nous ne voyons pas de chemin réaliste permettant à notre logiciel d’acquérir une conscience » déclarait d’ailleurs à ce sujet Andrew Ng, un spécialiste renommé du machine learning (apprentissage automatique).

Et si le risque c’était l’homme et non l’IA ? « Une machine peut être autonome au sens technique du terme : elle peut effectuer une chaîne d’actions (capter des informations, prendre une décision puis agir) sans que l’homme intervienne, à part en amont. Cela n’est pas dangereux en soi, car la machine est soumise au but que l’homme lui a donné » ajoutait-il. Des dérives découlant de l’utilisation de ces technologies sont possibles. La FTC, le régulateur américain du commerce, souligne ainsi dans un rapport récent les risques potentiels d’exclusion engendrés par l’exploitation d’algorithmes (qui peuvent faire appel à de l’IA) appliqués au Big Data. Mais la source de ces risques n’est pas alors l’IA elle-même, mais l’auteur ou l’exploitant des algorithmes, par exemple au travers d’un usage tourné essentiellement vers la maximisation du profit, et négligeant l’intérêt des consommateurs, la législation ou portant « atteinte à des valeurs fondamentales d’inclusion et d’équité. » Et ces risques sont sans doute bien plus plausibles que l’émergence d’une intelligence artificielle malfaisante asservissant la race humaine. « Il pourrait y avoir, dans un futur lointain, une race de robots tueurs, mais je ne travaille pas aujourd’hui à éviter de rendre l’IA malveillante pour la même raison que je ne m’inquiète pas du problème de surpopulation sur la planète Mars » commentait Andrew Ng lors de la conférence GTC 2015.

|

Source : Intelligence artificielle – La France a peur. Mais de quoi au juste ?